Энтропия (от греч. ἐντροπία — поворот, превращение) — понятие, впервые введенное в термодинамике для определения меры необратимого рассеивания энергии. Термин широко применяется и в других областях знания: в статистической физике как мера вероятности осуществления какого-либо макроскопического состояния; в теории информации как мера неопределенности какого-либо опыта (испытания), который может иметь разные исходы, в исторической науке, для экспликации феномена альтернативности истории (инвариантности и вариативности исторического процесса).

Энтропия — функция состояния системы, равная в равновесном процессе кол-ву теплоты сообщенной системе или отведенной из системы.

Энтропия — связь между макро и микро состояниями, единственная функция в физике, которая показывает направленность процессов. Функция состояния системы, которая не зависит от перехода из одного состояния в другое, а зависит только от начального и конечного положения систем

Термодинамическая энтропия— функция состояния термодинамической системы

Информационная энтропия — мера хаотичности информации, связана с вероятностью появления тех или иных символов при передаче сообщений.

Номера энтропии используются в математической теории метрических пространств для измерения размеров наборов (и,частично,фракталов).

Энтропия в теории управления — мера неопределенности состояния или поведения системы в данных условиях.

Энтропия в биологической экологии— единица измерения биологической вариативности.

Существует ли энтропия времени?

Да, если мы посмотрим на время, как на меру вероятности осуществления события.

Событие - факт который может произойти, либо не произойти в результате некоторого опыта.

Достоверное событие - событие, которое происходит с вероятностью 1

То есть в результате конкретного опыта оно не может не произойти. Оно происходит всегда

Недостоверное событие - событие, вероятность осуществления которого равна 0

В результате конкретного опыта оно не может произойти. Не происходит никогда

Случайное событие - событие, которое при осуществлении совокупности событий может либо произойти, либо не произойти.

События несовместны, когда появление одного события, исключает появление двух других событий в одном и том же опыте.

Статистический вес события W - число способов, каким оно может произойти.

Статический вес системы событий равен сумме статических весов ее элементарных событий

Энтропия системы событий S равна сумме энтропий элементарных событий ее составляющих.

Формула Планка из интернета:

S= klnW

S - энтропия, W- статистический вес события, ln - логарифм по основанию e. e - иррациональное число 2,718281828459045…, k - постоянная, названная в честь Больцмана, который изучая термодинамические системы пришел к мысли об энтропии, как логарифме вероятности состояния системы.

Теперь, пожалуйста, простыми словами.

Чем больше случайных событий в системе, тем больше в ней беспорядка.

Информация, не уложенная в структуру - каша в голове.

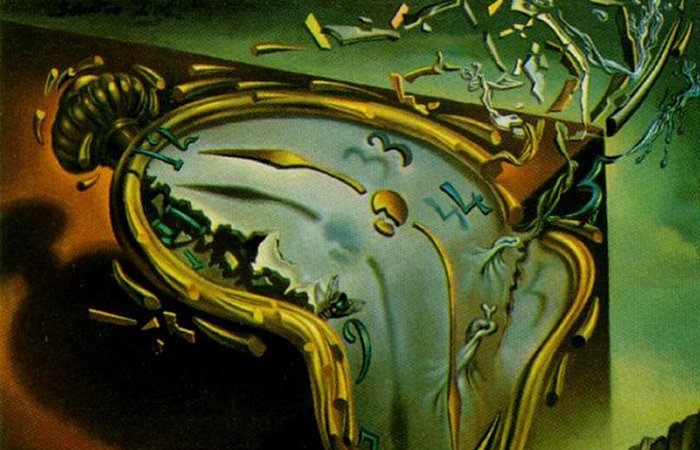

Время в пространстве движется от абсолютного порядка к абсолютному беспорядку.

Это почему?

Потому что движется. Вселенная расширяется. Время привязано к пространству.

Пространственно-временной континуум.

Теория тепловой смерти Вселенной признана несостоятельной из-за заданных начальных условий однородного, изотропного расширения. Выяснилось, что расширение Вселенной неоднородно и неизотропно. А значит система с точки зрения термодинамики неравновесна.

Ты заметила, что мы все время смешиваем дисциплины?

Вейник так вывел свою Общую теорию. Так почему же время движется в сторону беспорядка?

Представь, цепь событий, мировая линия. Каждое событие имеет координаты: три пространственных, одну временную. Чем определяется направление движения в пространстве-времени? Вероятностью наступления того, или иного события. Происходит то, что наиболее вероятно. Наиболее вероятно, то есть имеет наибольший статистический вес. А как энтропия связана с вероятностью, мы смотрели. Выше формула. Чем больше статистический вес события, тем больше значение энтропии

Я посмотрела, чему равна постоянная Больцмана. 1,38*10^-23. В итоге речь идет об очень малых величинах.

:) Дело не в количественных характеристиках, а в причинно-следственных связях. Чем больше у события способов осуществления, тем выше энтропия системы, обуславливаемой этими событиями. Сколько событий во Вселенной? Сколько в ней атомов? Не первичных. Сколько их количественно на всех планах? Каждый атом - событие.

Ну, если так смотреть… Хорошо, что постоянная Больцмана такая маленькая в числовом выражении… Поговорим о негэнтропии

Негэнтропия - отрицательная энтропия. Мера упорядоченности и организованности системы.

Негэнтропия противоположна энтропии и имеет отношение к живым системам — к тому, что более упорядочено и более определённо в сравнении с системами косной материи.

Жизнь, как полагают, является негэнтропичной, потому что потребляет то, что имеет меньшую упорядоченность (мёртвая пища) и превращает это в то, что имеет большую упорядоченность (клетки в теле, тканях и органах). При этом возрастает температура. Внешняя сторона живой системы, или кожа организма, всегда имеет максимальную энтропию в теле, потому что она удаляет тепло.

Негэнтропия, основанная на идеях, противоположных идеям энтропии, имеет отношение не к системам косной материи, а к живым системам. Клифф Джослин (Cliff Joslyn) предложил ряд способов измерения негэнтропии, отличных от измерения тепла, исходящего от тела. Живые существа, ищущие с целью выживания эти способы, создают модели, которые более упорядочены, чем то, что измеряется, эти модели объединяются, обдумываются, возникающая в итоге наука негэнтропична как любая часть жизни.

Идея, что живые существа упорядочивают вселенную, называется человеческим принципом. Он имеет сильную форму, которая говорит, что

|

Люди призваны, чтобы сделать это. |

И слабую или очевидную форму, которая говорит, что

Всеми проблемами, где жизнь вписывается в модели нашей вселенной, также интересуется космология.Время в науке определяется как направление возрастания энтропии. Такое определение весьма затрудняет определение времени, которое относится к негэнтропии и живым системам. Негэнтропия — не единственная идея о жизни, которая затрагивает наши представления о времени. Большинство инженеров полагается на линейное время для анализа риска, экономика — на циклическое время как деловой цикл, биология исследует ритмичное время особенно в системах коммуникации животных. Теперь, загляни в формулу, связывающую статистический вес события и энтропию. Когда значение энтропии становится отрицательным? Когда статистический вес w меньше единицы. Например 0,5. Но по определению, W больше, или равен единице всегда. То есть, меньше единицы он быть не может… Где же применимо понятие отрицательной энтропии? В квантовой теории информации. Квантовая информация - это информация о состоянии квантовой системы. Это основной объект исследования в квантовой теории информации и может управляться с помощью методов квантовой обработки информации. Квантовая информация относится как к техническому определению в терминах энетропии фон Неймана, так и к общему вычислительному термину. Оптические решетки используют лазеры для разделения атомов рубидия (красного цвета) для использования в качестве информационных битов в квантовых процессорах с нейтральным атомом - прототипах устройств, которые разработчики пытаются превратить в полноценные квантовые компьютеры. Это междисциплинарная область, которая включает в себя квантовую механику, информатику, теорию информации, философию и криптографию среди других областей. Ее изучение также имеет отношение к таким дисциплинам, как когнитивная наука, психология и нейробиология. Ее основной задачей является извлечение информации из материи в микроскопическом масштабе. Наблюдение в науке является одним из наиболее важных способов получения информации, и для количественной оценки наблюдения требуется измерение, что делает его критически важным для научного метода. В квантовой механике из-за принципа неопределенности некоммутирующие наблюдаемые не могут быть точно измерены одновременно, поскольку собственное состояние в одном базисе не является собственным состоянием в другом базисе. Согласно связи собственное состояние–собственное значение, наблюдаемое является четко определенным (определенным), когда состояние системы является собственным состоянием наблюдаемого. Поскольку любые две некоммутирующие наблюдаемые не являются одновременно четко определенными, квантовое состояние никогда не может содержать окончательную информацию об обеих некоммутирующих наблюдаемых. Информация - это нечто физическое, закодированное в состоянии квантовой системы. В то время как квантовая механика занимается изучением свойств материи на микроскопическом уровне, квантовая информатика фокусируется на извлечении информации из этих свойств, а квантовые вычисления манипулируют и обрабатывают информацию – выполняют логические операции – с использованием методов квантовой обработки информации. Квантовая информация, как и классическая информация, может быть обработана с помощью цифровых компьютеров, передана из одного места в другое, обработана с помощью алгоритмов и проанализирована с помощью компьютерных наук и математики. Так же, как основной единицей классической информации является бит, квантовая информация имеет дело с кубитами. Квантовую информацию можно измерить с помощью энтропии фон Неймана. S(p) = − tr(p lnp) tr - сумма элементов на главной диагонали матрицы плотности от верхнего левого до нижнего правого угла (матрица квадратная) ln p - натуральный логарифм матрицы плотности. Матрица описывает квантовое состояние физической системы. Позволяет вычислять вероятности результатов любого измерения, выполняемого в этой системе Опуская непонятные тебе математические выкладки, скажу, что в формуле присутствует знак минус, потому что измеряется не количество неопределенности, а количество определенности. Неопределенность в результатах квантовых вычислений ни к чему:) Значение энтропии может быть и положительным и нулевым. Что такое матрица плотности? Она использована в формуле Нелинейное распределение значений опыта. Когда у события не одна предпосылка, а две. У следствия две причины. Это для двухфакторных систем… Для начала Нас не поймут…. Так что же время и его негэнтропия? Дугин в лекциях говорил о том. О задаче человечества по спасению времени. Он так не говорил… Немного я иронизирую. О том речь, чтобы вспомнить вечность в себе. Как выше было сказано негэнтропия характерна для живых систем. Они строят из хаоса порядок. И тем спасают время от исчезновения. Вечность - время не привязанное к пространству. Вне континуума. Когда вы перестаете как белка колесо крутить, когда забиваете на все и вниманием уходите внутрь себя, в самую середку, в тишину, вы возвращаете времени его исконный смысл - я есмь. Вечность как источник смысла события. О том поразмышляй… Я очень, очень тебя благодарю Чаще говори со мною. Не прощаюсь.

|

Я так ощущаю, что ЭТО мне понятно!: "О том речь, чтобы вспомнить вечность в себе. Как выше было сказано негэнтропия характерна для живых систем. Они строят из хаоса порядок. И тем спасают время от исчезновения. Вечность - время не привязанное к пространству. Вне континуума. Когда вы перестаете как белка колесо крутить, когда забиваете на все и вниманием уходите внутрь себя, в самую середку, в тишину, вы возвращаете времени его исконный смысл - я есмь. Вечность как источник смысла события. О том поразмышляй…". Очень, Очень ВАС Благодарю!!!!

"Чаще говори со мною. Не прощаюсь." - Иришка, а КТО говорил?

Ой, Иришка, какая же ты Молодец!!! Такие чены принимаешь!!! Я мало что понимаю, но меня завораживают ваши такие исследования, тебя и твоих Направителей!!! БЛАГОДАРЮ!!!

Благодарю